Des chercheurs indiens ont conçu une intelligence artificielle permettant de rendre les mouvements des lèvres plus réalistes lors du doublage et de la traduction vidéo.

Les logiciels de traduction vocale de vidéo sont maintenant de plus en plus courants. Cette technique consiste à traduire une voix d’une vidéo dans une autre langue tout en conservant la même image. Une sorte de doublage de robot, souvent mal réalisé. Surtout lorsque la langue d’origine et celle de traduction sont fondamentalement différentes. C’est par exemple le cas de l’hindi et de l’anglais, très éloigné en termes d’élocution. La synchronisation entre la voix traduite et le mouvement des lèvres est donc généralement ratée.

Ces erreurs de synchronisation font peut-être partie du passé grâce à cet algorithme développé par des chercheurs indiens de l’Institut international des technologies de l’information de Hyderabad. L’intelligence artificielle qu’ils ont créé permet de traduire automatiquement une vidéo en synchronisant le mouvement des lèvres, pour rendre l’ensemble plus réaliste.

Toutes les étapes du doublage

Le site Presse-citron nous explique que ce système recourt à la reconnaissance vocale pour convertir d’abord la voix originale en texte. Le logiciel traduira ensuite ce texte dans la langue souhaitée, puis génèrera à à partir de cette traduction une voix de synthèse appropriée. Un modèle toutefois spécialement conçu pour les langues régionales indiennes (normal, vu l’origine des chercheurs).

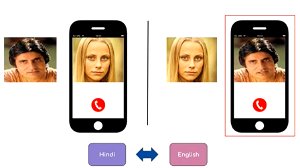

L’intelligence artificielle, de son nom LipGAN, prend ensuite le relais pour générer des images de façon réaliste. Ces algorithmes modifient le mouvement des lèvres de manière à faire correspondre le mieux possible la voix traduite et l’image de la vidéo originale.

Autrement dit, le logiciel prend en charge toutes les étapes du doublage classique (sans humain): il traduit le texte, le convertit en voix (de synthèse), insère celle-ci sur l’image… Et synchronise le tout pour un mouvement des lèvres adapté au texte. Pour être précis, c’est de la ‘traduction en face-à-face’. Petite illustration en vidéo ci-dessous si vous avez du mal à imaginer la manœuvre et toutes ses possibilités.

Ses utilisations sont multiples: cette IA permet par exemple de corriger un mauvais doublage cinéma (la parole n’est pas bien synchronisée avec le mouvement des lèvres de l’acteur) ou d’intégrer carrément une voix de synthèse sur un visage tout en gardant une expression réaliste.

Pour ce faire, ce logiciel se base sur la deepfake, une technique de montage consistant à remplacer un visage par un autre dans une vidéo et permettant de faire dire n’importe quoi à n’importe qui. La bête noire de Facebook.

- Lire aussi: Les “deepfakes”: des apps permettent de remplacer le visage de stars de porno en pleine action par… le vôtre

Imperfections

Le résultat peut faire encore un peu peur, mais il est bien plus réaliste au niveau du mouvement des lèvres qu’une mauvaise traduction vidéo. Un système particulièrement utile pour les spectateurs indiens avec leurs nombreuses spécificités locales. Les vidéos traduites automatiquement laissent souvent à désirer au niveau du réalisme du mouvement des lèvres, ne correspondant pas à ce qui est dit. Tout comme certains doublages de films mal réalisés, où la voix et l’expression de l’acteur ne correspondent pas.

Il reste tout de même des améliorations à y apporter pour atteindre le ‘doublage’ ultime. Des erreurs persistent, notamment lorsque le système doit gérer la présence de plusieurs visages à l’écran ou lors de phases d’action trop ‘mouvementées’. Et comme vous pouvez le voir sur la vidéo ci-dessus, l’expression des visages doit encore s’améliorer, une fois le contenu traduit. Mais les chercheurs affirment y travailler d’arrache-pied, afin de peut-être pouvoir suivre leurs séries internationales préférées comme si elles venaient de chez eux.

Lire aussi: